在人工智能技術浪潮席卷全球的今天,數據智能產品正以前所未有的深度和廣度重塑各行各業。從精準的推薦系統、智能的自動駕駛,到高效的工業質檢、前沿的藥物研發,其核心驅動力無不源于海量、多樣、高速流動的數據。在這光鮮的應用層之下,一個常被忽視卻至關重要的基石正在默默支撐著整個智能體系的運轉——那便是強大、可靠且智能化的存儲支持服務。

一、數據洪流:AI時代對存儲的根本挑戰

傳統的數據存儲方案,在面對AI工作負載時,正遭遇著前所未有的壓力。這主要體現在三個方面:

- 規模與成本的矛盾:AI模型的訓練需要吞吐PB級乃至EB級的原始數據。存儲如此海量的數據,同時控制不斷攀升的硬件與運維成本,成為首要挑戰。

- 性能與效率的瓶頸:訓練過程需要存儲系統能夠以極高的吞吐量和低延遲,同時向成千上萬個計算節點(GPU/TPU)供給數據。任何I/O瓶頸都會導致昂貴的算力資源閑置,極大拖慢模型迭代速度。

- 數據管理的復雜性:AI數據生命周期復雜,從采集、清洗、標注、版本管理,到訓練、推理、歸檔,每個階段對數據的訪問模式、性能要求和存儲成本都不同。如何實現數據的統一管理、無縫流動和智能分層,是提升整體效率的關鍵。

二、智能存儲:從被動容器到主動賦能

為應對上述挑戰,現代存儲支持服務正在發生深刻演變,其核心是從簡單的“數據存放處”進化為“數據賦能平臺”。

1. 高性能并行文件系統與對象存儲的融合

針對訓練場景,高性能并行文件系統(如Lustre, GPFS, WekaFS)因其極高的聚合帶寬和元數據性能,成為承載熱數據、加速訓練過程的首選。與此對象存儲(如AWS S3, 開源Ceph)憑借其近乎無限的擴展性和成本優勢,成為海量冷數據、模型checkpoint和數據集歸檔的“數據湖”底座。前沿的存儲服務正通過智能緩存、透明分層等技術,將二者無縫融合,讓數據在高速層與大容量層之間按需、自動流動。

2. 存算分離與云原生架構

存算分離架構已成為主流。計算資源(GPU集群)與存儲資源獨立彈性伸縮,避免了因存儲容量或性能不足而整體擴容計算集群的浪費。結合Kubernetes等云原生技術,存儲服務能夠以容器化的方式動態提供,實現存儲資源的敏捷部署、按需供給和精細化管理,完美適配AI訓練任務快速啟停、彈性伸縮的特點。

3. 數據感知與智能管理

最前沿的存儲系統正在融入AI技術本身,實現“以AI管理AI數據”。例如:

- 智能數據預取與緩存:系統能夠學習訓練任務的數據訪問模式,主動將所需數據預加載到高速緩存中,進一步消除I/O等待。

- 自動化數據生命周期管理:基于策略與數據熱度分析,自動將不活躍的數據從高性能存儲遷移到低成本存儲,優化總體擁有成本(TCO)。

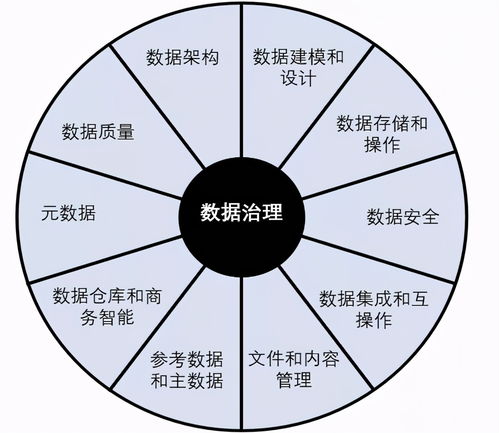

- 元數據增強與數據治理:提供強大的元數據管理能力,支持數據溯源、版本控制、血緣分析,并與MLOps平臺深度集成,確保數據質量、合規性與可重復性。

三、未來展望:存儲即智能基礎設施

存儲支持服務在AI生態中的角色將愈發核心和主動。我們或將看到:

- 存儲與計算的更深層協同:通過計算存儲(Computational Storage)或近數據處理(Near-Data Processing)技術,將部分數據過濾、預處理任務卸載到存儲層內部執行,極大減少不必要的數據移動,提升整體能效。

- 面向AI工作負載的專用硬件與協議:隨著DPU/IPU的興起,存儲的智能卸載和加速能力將更強。NVMe-oF等高性能網絡存儲協議將進一步普及,實現數據中心級的高性能共享存儲池。

- 跨云、邊、端的統一數據平面:為支持聯邦學習、邊緣推理等場景,存儲服務需要提供一個全局統一的數據訪問、同步和管理視圖,確保數據與模型在中心、邊緣和終端之間安全、高效地協同。

###

在數據智能產品與技術飛速發展的前沿,存儲支持服務已不再是后臺的默默支撐者,而是直接決定AI研發效率、創新速度和落地成本的關鍵賦能層。只有構建起能夠理解數據、感知業務、動態優化的智能存儲基礎設施,我們才能真正釋放海量數據的潛能,讓AI的浪潮持續澎湃向前。對任何致力于在AI領域取得突破的組織而言,投資和優化其“存儲智慧”,與投資算力和算法同等重要。